摘要: 本篇内容将手把手带你使用Ollama+Open WebUI本地部署DeepSeek,并借助 贝锐花生壳内网穿透,轻松实现安全远程访问,让你随时随地畅享个人专属AI! 相比直接将服务部署在云端或使用端口映射进行远程访问,贝锐花生壳内网穿透不仅让远程连接更便捷,还...

本篇内容将手把手带你使用Ollama+Open WebUI本地部署DeepSeek,并借助 贝锐花生壳内网穿透,轻松实现安全远程访问,让你随时随地畅享个人专属AI!

相比直接将服务部署在云端或使用端口映射进行远程访问,贝锐花生壳内网穿透不仅让远程连接更便捷,还能有效防止未经授权的用户擅自访问本地部署的Ollama,全面保障AI资源的私密性与安全性!

一键开启:Ollama + DeepSeek 模型部署

首先,进入 Ollama 官网,按照提示几步就能轻松完成安装。

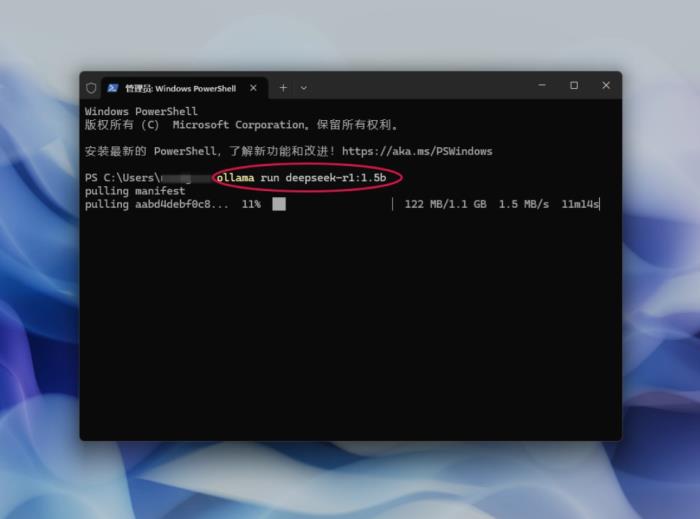

安装好 Ollama 后,打开命令提示符,参考命令“ollama run deepseek-r1:1.5b”一键下载,DeepSeek-R1 模型就会开始下载安装。

这里给大家个小建议,DeepSeek-R1 提供了从 1.5B 到 671B 的多种参数选择,大家可以根据自己电脑的显存大小来挑选合适的参数,4G 显存选 1.5B、8G 选 7B、16G 选 14B,这样能保证模型运行更顺畅。

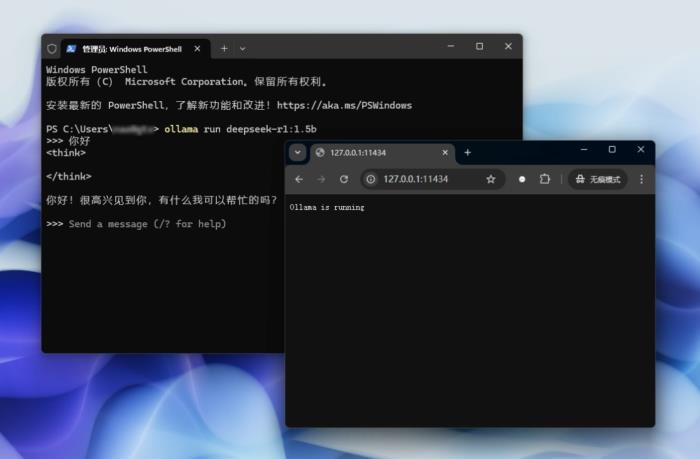

Ollama默认仅开启本机访问(无法外部或远程访问)完成上述步骤后,即可在本机通过命令行,或通过http请求实现访问,返回以下结果说明已经正常运行。

图形化交互:Docker 部署 Open WebUI

除了通过命令行与 DeepSeek 交互,我们还可以用 Open WebUI 实现更友好的图形化界面操作。不过在此之前,得先确认电脑上安装并运行了 Docker,要是还没安装,需要去 Docker 官网一键下载安装。

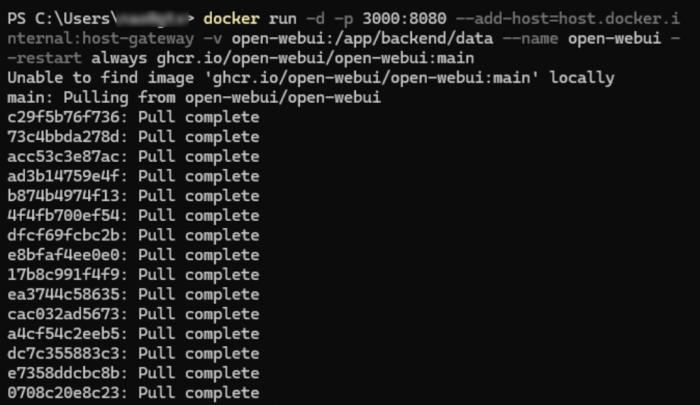

接下来,通过 Docker 部署 Open WebUI :

输入“docker run -d -p 3000:8080 --add - host=host.docker.internal:host - gateway - v open - webui:/app/backend/data --name open - webui --restart always”这条命令。如果希望通过其他方式部署,大家也可以自行查看OpenWebUl github主页的教程。

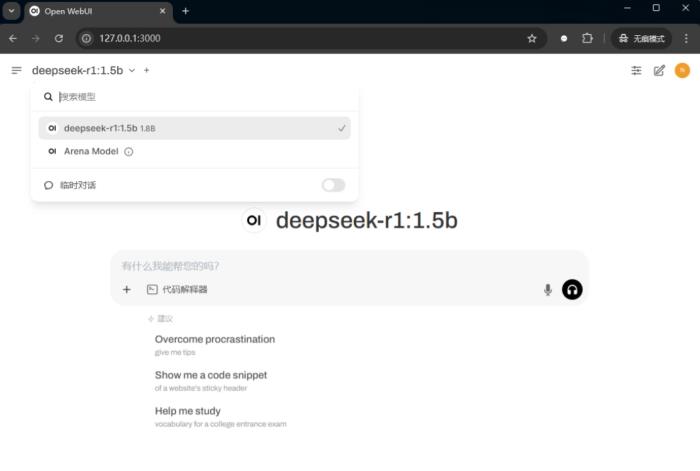

完成Open WebUl部署后,打开浏览器,浏览器通过本机IP:127.0.0.1+预设的访问端口3000即可打开OpenWebUl。

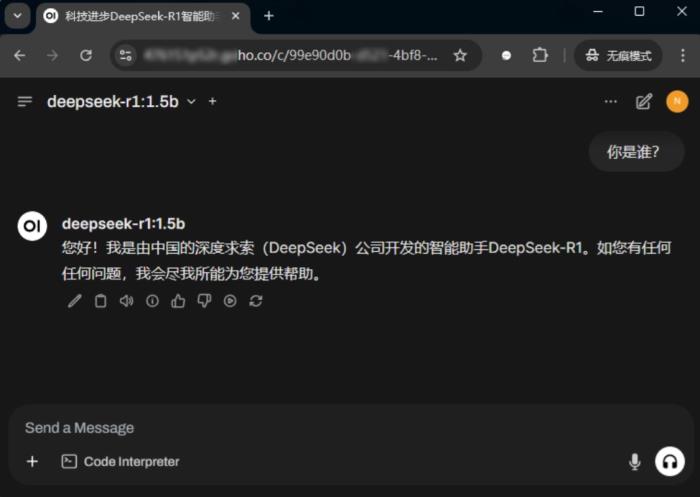

这时候,完善一下本地管理员账号信息,它就已经自动连接到本地的 Ollama 了,选择好模型,就能直接在本地享受图形化交互的便捷。

利用贝锐花生壳内网穿透,实现安全远程访问

无需公网IP,简单3步完成部署

如果想随时随地远程访问本地部署的 DeepSeek,可以利用贝锐花生壳内网穿透,简单三步即可部署,轻松实现远程访问。

第一步,先注册一个贝锐账号,然后下载并登录花生壳客户端。

第二步,进入花生壳云管理平台,填写 Open WebUI 局域网 IP 和默认端口 “3000”,并设置安全访问规则。

值得一提的是,贝锐花生壳生成的访问地址支持无需本地部署证书,一键采用HTTPS协议,可实现全程加密传输,充分保障数据的私密性和安全性。

特别是对于Open WebUI的网页界面,花生壳额外支持加密验证,筑起双重防护屏障。

第三步,完成设置后,点击保存,就会自动生成一个外网访问地址,随时随地安全访问!

整个过程简单高效,无需复杂操作,也无需依赖云服务器,即可打造专属的AI助手!

贝锐花生壳强大防护能力,保障安全远程访问

不仅如此,贝锐花生壳还提供精细化访问权限控制、爆破防护等高级功能增值服务。它可以基于时间周期、IP 地址 / 区域、浏览器 / 系统版本等条件来判断是否允许访问,自动阻止未经授权的访问请求,再也不用担心私有服务暴露在公网。

通过以上这些步骤,我们不仅成功实现了 DeepSeek 的本地私有化部署,还借助贝锐花生壳轻松解锁了远程访问,整个过程简单高效,无需复杂操作,也无需依赖云服务器,就能打造专属的 AI 助手。

转自:https://www.fromgeek.com/daily/1044-675181.html