有两个前置条件,在这里游侠不赘述,因为无论是在Windows电脑,还是在macOS电脑,安装这两个软件都几乎是“NEXT”一路点下去就可以了,下载地址游侠说一下:

- Ollama,一个简明易用的本地大模型运行框架,目标是帮助开发者在本地运行、创建和共享大型语言模型。Ollama 还提供了一个模型库,开发者可以在这里下载和使用各种开源模型。Ollama 还提供了一种名为 Modelfile 的文件格式,开发者可以使用它来定义和创建自定义模型。Ollama支持Windows、macOS和Linux,下载地址在这里 https://ollama.com/download

- Docker:Docker 是一个开源的应用容器引擎,让开发者可以打包他们的应用以及依赖包到一个可移植的镜像中,然后发布到任何流行操作系统的机器上,也可以实现虚拟化。在本文中的主要作用是给Ollama中的模型一个可视化的UI,就是你对话的窗口!也是同时支持Windows、macOS和Linux。在这里下载 https://www.docker.com/products/docker-desktop/

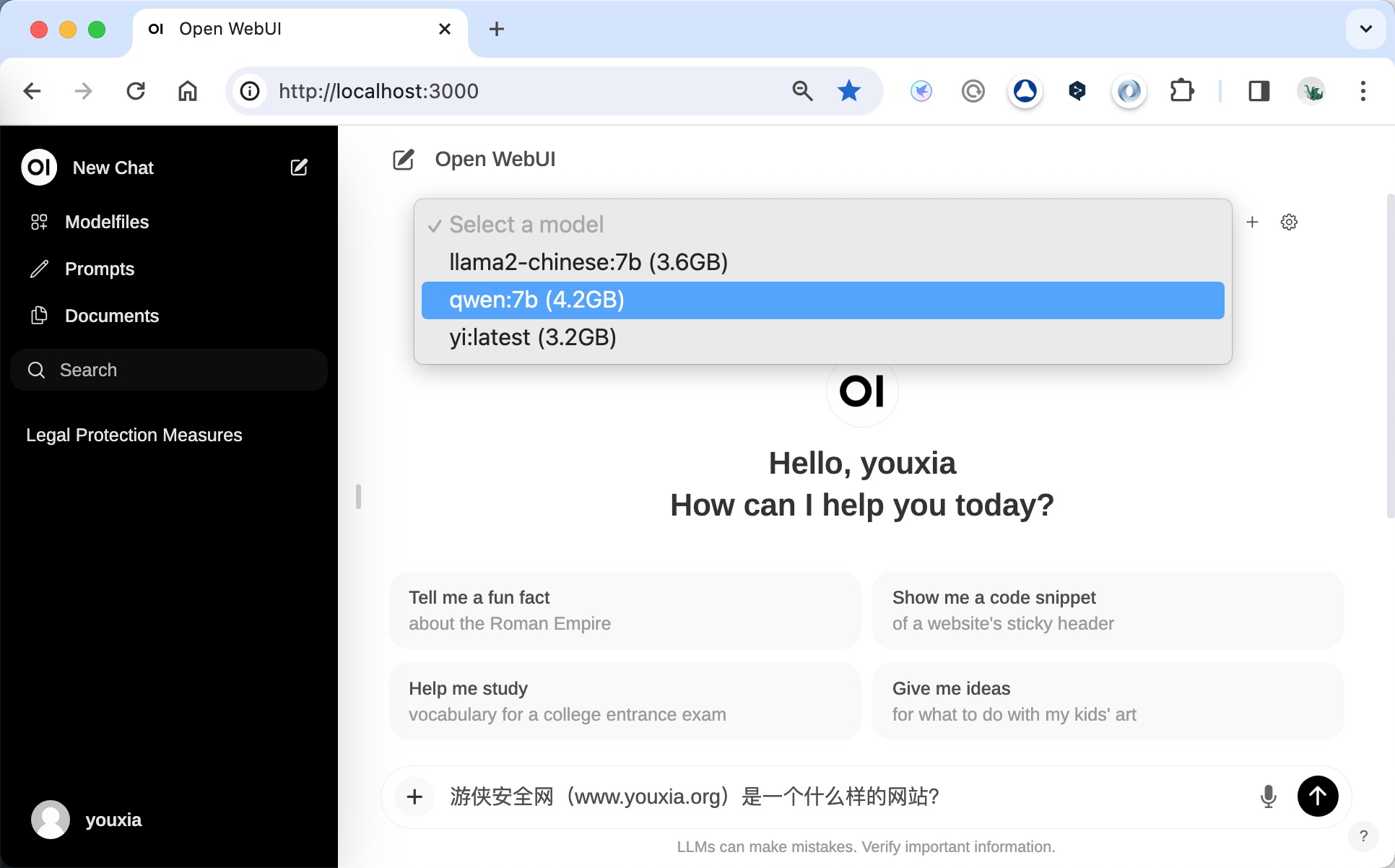

嗯,上面两个部署完成后……运行……然后你可以在 https://ollama.com/library 这里看到Ollama支持的模型,如gemma、llama2、mistral、mixtral、llava等,可以通过命令直接下载模型,如常见的几个中文模型的命令是:

- ollama run llama2-chinese:7b

- ollama run yi

- ollama run qwen:7b

到这里,你已经把所有的工作完成了,但是,你需要一个UI来对话,对吧?这就是上面安装Docker的意义。下面我们在Docker中部署 open WebUI,输入下面的命令:

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:main

嗯,不出什么意外的话(出意外我也搞不定),你可以在Docker中发现open-webui已经部署完毕,直接在浏览器中输入 http://localhost:3000/ 就可以体验本地大模型的魅力了!(首次打开需要注册一个账号)

作者:张百川(网路游侠)网站:https://www.youxia.org 转载请注明来源!谢谢合作